Gérer les vulnérabilités des systèmes embarqués et IoT avec l’IA : rêve ou réalité ?

Le 29/08/2025

Gérer les vulnérabilités de ses systèmes est devenu indispensable dans le monde embarqué et IoT ; pour garantir la sécurité des produits et des utilisateurs tout d’abord, mais également pour se conformer aux exigences réglementaires en cybersécurité, à l’image du Cyber Resilience Act européen.

Et si l’IA permettait de gagner du temps sur ce travail parfois fastidieux ?

Après tout, ne serait-ce pas le rêve secret de beaucoup d’équipes R&D ?

L’IA : une solution pour accélérer l’analyse des vulnérabilités ?

De belles promesses

On imagine déjà les bénéfices d’utiliser l’IA pour ce genre de maintenance :

- Gain de temps: Des agents conversationnels basés sur des grands modèles de language tels que ChatGPT ou Copilot vont permettre de repérer des tendances et des anomalies qui pourraient échapper à une analyse manuelle de longues listes de vulnérabilités. Ils automatisent l’analyse des données et livrent des résultats en temps réel pouvant alors faire gagner un temps non négligeable aux équipes de développement.

- Réduction des coûts: L’évaluation automatisée par l’IA réduit l’effort humain nécessaire. Résultat : moins de ressources à mobiliser pour la qualification et la résolution des vulnérabilités, ce qui permet de libérer du temps pour des tâches à plus forte valeur ajoutée, comme le développement applicatif.

Des atouts spécifiques à chaque étape du cycle de vie des CVE

La gestion des vulnérabilités se divise en trois phases principales, où l’IA peut jouer différents rôles :

- Détection: L’IA peut s’avérer précieuse dans la première phase, en détectant les vulnérabilités à partir d’une SBOM (Software Bill of Materials, i.e une liste de paquets logiciels) transmise à un LLM (Large Language Model, i.e. un modèle linguistique avec un très grand nombre de paramètres basé sur des réseaux de neurones). Celle-ci pourra identifier les CVE (Common Vulnerabilities and Exposures) critiques applicables à votre système embarqué.

- Evaluation : L’IA peut aussi se révéler utile lors de la phase 2 en fournissant des informations sur les CVE détectées et rendre plus simple l’examen de leur impact et pertinence pour votre produit notamment en proposant une interface en langage naturel très efficace permettant de «discuter» d’une CVE et de son applicabilité en incorporant un contexte élargi basé sur des recherches Internet.

- Remédiation: Corriger les vulnérabilités implique majoritairement des interventions humaines, pour l’application de correctifs ou de mises à jour, et l’IA n’intervient pas encore dans ce processus.

Consultez cet article pour plus de détails sur la gestion du cycle de vie des vulnérabilités.

Ce que les travaux de recherche nous apprennent

L’utilisation de LLM pour la gestion des vulnérabilités n’en est encore qu’à ses balbutiements et les retours de la recherche sur ce sujet sont encore limités.

Une des rares expériences sur le sujet nous provient de Siemens Healthcare. En 2025, leurs équipes ont créé leur propre LLM, formé à partir de leurs bases de données regroupant des années d’analyses manuelles de vulnérabilités sur leurs systèmes. Ce modèle interne servait à évaluer les CVE tout en restant sous la supervision d’un expert en cybersécurité, afin de garantir la fiabilité des résultats.

Cette expérience a permis d’identifier plusieurs limites récurrentes de l’IA :

- Hallucinations: L’IA peut parfois omettre ou inventer des informations essentielles pour l’analyse, la résolution ou la communication autour des vulnérabilités (comme les versions logicielles concernées, les recommandations de correction ou le nom des composants affectés).

- Texte hors sujet: Les modèles de langage génèrent souvent du contenu inutile ou peu pertinent, ce qui complique la lecture et la validation des CVE.

- Difficulté avec de longs textes: Le traitement de longues listes de vulnérabilités reste complexe pour l’IA. Une meilleure approche consiste à découper le texte et appliquer une analyse détaillée pour chaque cas.

L’étude menée chez Siemens Healthcare a montré qu’un modèle d’IA interne, bien entraîné sur un vaste historique de données, peut réellement aider les spécialistes en cybersécurité à identifier rapidement les failles importantes et à transmettre les informations adéquates aux parties prenantes.

Cependant, malgré ces avantages, une IA seule n’est pas suffisante pour gérer tout le cycle de vie des vulnérabilités dans les systèmes IoT ou garantir la conformité réglementaire en cybersécurité.

Pourquoi les LLM publics ne sont (pas encore ?) prêts

Dans cette section, nous nous concentrerons sur les LLM publics – modèles d’IA accessibles au plus grand nombre, comme GPT-5 d’OpenAI – contrairement aux modèles internes bâtis et formés spécifiquement par une organisation (comme celui de Siemens Healthcare vu plus tôt) pour un usage privé et métier.

Le risque de passer à côté d’une CVE critique

Même si l’IA peut aider à identifier des vulnérabilités, rien ne garantit qu’une faille importante ne sera pas oubliée. En réalité aucun outil ne le peut, car la détection dépend en grande partie de la divulgation des vulnérabilités au sein de la communauté, et certaines resteront inévitablement inconnues.

Il est donc essentiel de ne pas s’appuyer uniquement sur l’IA pour ce type d’analyse, surtout dans une démarche de conformité au Cyber Resilience Act (CRA) qui requiert à la fois complétude et réactivité : toute vulnérabilité exploitable sur un produit doit être identifiée rapidement, validée, communiquée aux autorités, puis le cas échéant corrigée au moyen d’une mise à jour du produit.

Le risque de divulgation de données sensibles

L’usage de l’IA en cybersécurité soulève des questions d’éthique et de confidentialité. Les CVE sont directement associées à vos produits, et transmettre ces données à des services externes comme ChatGPT, Copilot ou autre, c’est risquer de voir des données sensibles redistribuées hors de votre organisation.

De tels incidents se sont déjà produits : ChatGPT a, par le passé, divulgué des informations confidentielles qui n’auraient jamais dû l’être…

Des défis d’intégration dans les processus DevOps

L’intégration de l’IA dans votre pipeline ou vos outils de gestion de vulnérabilités peut se révéler complexe. Les défis en matière d’interopérabilité, de structures de données différentes et la nécessité d’adapter finement chaque outil peuvent se révéler de vrais obstacles à l’adoption.

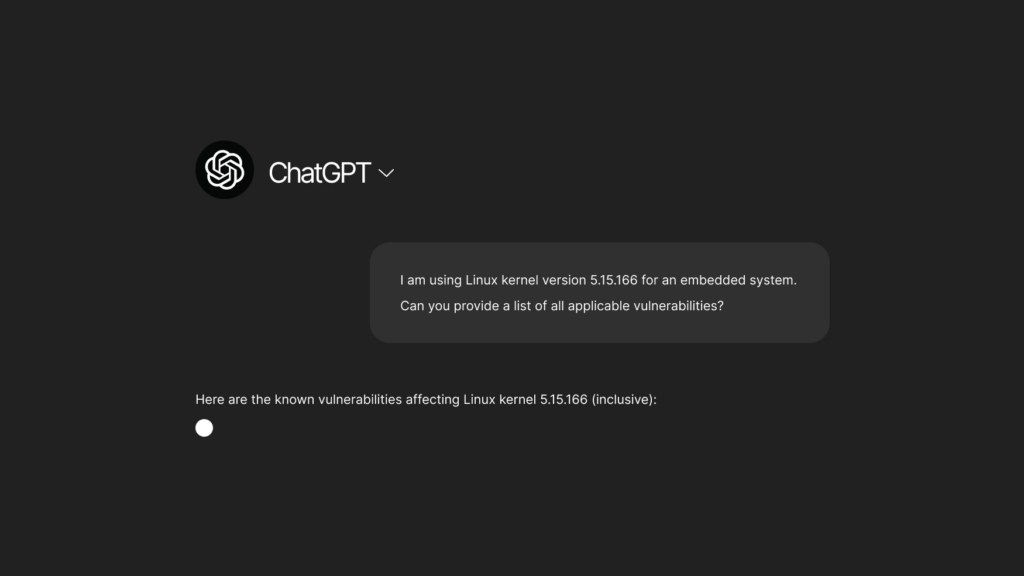

Exemples d’analyse générée par ChatGPT

Voici deux exemples d’analyses générées par ChatGPT autour d’une vulnérabilité Linux identifiée dans un produit IoT :

- Génération d’une liste de CVE applicables à un noyau Linux

- Demande d’informations sur la CVE-2023-4622

Dans le cadre de ces analyses, on peut remarquer que ChatGPT n’a pas de valeur ajoutée par rapport à d’autres outils non-basés sur l’IA dans pour la production d’une liste de CVE applicables (omission de nombreuses vulnérabilités importantes, faux positifs, erreurs).

En revanche le deuxième exemple souligne l’utilité d’un tel outil pour l’analyse d’une vulnérabilité donnée, en permettant d’accélérer la recherche d’information ainsi que le diagnostic sur un produit donné via la possibilité d’enrichir son contexte avec des informations techniques additionnelles telles que les logs git, les informations de configuration, etc.

Il convient néanmoins de ne pas prendre ces résultats pour acquis et de faire preuve de discernement : tout paramètre technique aboutissant à la validation ou non d’une vulnérabilité et à sa mitigation devra être confirmé à la main, afin de se prémunir des éventuelles hallucinations et incomplétudes.

Alors, IA ou pas IA pour gérer les vulnérabilités des systèmes embarqués ?

Il apparaît aujourd’hui que l’intelligence artificielle n’est pas suffisamment aboutie pour couvrir l’ensemble du cycle de vie des vulnérabilités dans les systèmes embarqués et IoT. Bien que les LLM puissent apporter une aide ponctuelle, notamment pour l’analyse et la qualification d’une CVE spécifique, il reste essentiel de s’appuyer sur des sources fiables afin d’assurer la qualité des informations et de limiter les risques de fuite de données sensibles.

L’utilisation d’une IA interne constitue une piste intéressante pour renforcer la sécurité, puisqu’elle permettrait alors de garder le contrôle sur les données confidentielles. Cette approche exige néanmoins une adaptation technique approfondie et des ressources conséquentes pour répondre précisément aux besoins de votre organisation.

Enfin, des outils spécialisés, comme CVEScan de The Embedded Kit, offrent aujourd’hui une alternative robuste. S’appuyant sur les bases publiques de CVE et des filtres avancés, CVEScan facilite l’identification, l’analyse et le suivi des vulnérabilités tout en minimisant les faux positifs. Même sans recourir à l’IA, cette solution permet de gagner du temps et d’optimiser la gestion des risques liés aux systèmes embarqués.

Retrouvez l’équipe The Embedded Kit à Lyon Cyber Expo et au SIDO sur le stand O208.